腾讯词库采用 知识共享署名 3.0协议

但是腾讯应该没想到用这个词库可以做出一个高质量的输入法码表。

腾讯会不会紧急把这个分词数据撤下来?

吓得我赶紧把tencent-ailab-embedding-zh-d100-v0.2.0.tar.gz tencent-ailab-embedding-zh-d200-v0.2.0.tar.gz做了备份。

另外,二者的交集目前发现这对于以词语为输入单元的输入方式是极好的。

这样主要以词语语义上的分割对2471万的词库缩减对整句输入是不利的

目前只发现一个例子

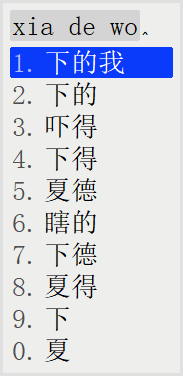

鸿雁拼音腾迅测试版·全拼方案 下的候选词语列表

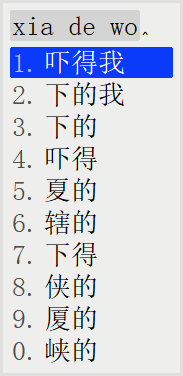

鸿雁拼音·全拼 2471万增强版 下的候选词语列表

“吓得我”在语义上分割为 “吓” “得” “我”

机械分词将这三个字组成的词语看作一个整体。

如果要做成最完美的输入方案。

不但要在语义学上进行词语拆分,而且要输入法使用的时候对词语按照语义学的语法逻辑进行组合。

这个难度就大得多了。

腾讯词库的训练采用了大规模的数据,而且采用了先进的算法,一般人没这个功夫去研究这些,除非高薪聘用的研究员。

科学是没有尽头的,了解得越多越能发现自身的无知。