谢谢告知这个音标数据源,我稍微搜过都没找到。看了一下法文音标,质量好像还可以,但跟词典图像对比过之后,发现不少地方并不一致,比如 abaisser ,词典标为[abese],这个数据库则是 abaisser /abɛse/。或许法文发音同样有不少流变、方言等,不同人认可的正确语音并不一样,没有一个强制性的统一标准,像法兰西学院词典、Petit Larousse、 Dictionnaires Le Robert,都是不标注读音的,我这里在文本化《拉鲁斯法汉双解词典》,注音有分歧也只能以它作为标准参考了,而不能采用 ipa-dict 的音标数据。

不过这些已经不大重要,经过多轮替换,校订,目前词典音标数据的质量已有大幅度的提高,进一步打磨修正参照比对原书图像即可,工作量不会太大。

Deepl

2025 年9 月 30 日 02:58

169

不同的语言学家对同一音位的理解有分歧是很常见的。ipa-dict是专业语音学家制作的学术基础设施,音位分析的水平是要比绝大多数词典高的。如果ipa-dict和《拉鲁斯》有差异,那大概率是《拉鲁斯》的记音法做了不严谨的变通,或者纪录了常见但不标准的口音。(当然,这谈不上对错)

使用原词典的音标数据是绝对正确的,音标也是词典的重要组成部分,使用任何其他数据源来代替都是对词典的窜改。ipa-dict的数据只能作为一个校对音标时的参考。

或许可以通过分析词典和数据库的音位系统,排除记音法的差异后,再用ipa-dict的数据来核校《拉鲁斯》的音标。不过现在再说这种方法好像已经是马后炮了,AI都快把人类的活干完了。

现在应该先优化一下提示词:

用XML标签对提示词的内容结构进行划分和定义,让提示词在形式上达到绝对清晰。

告诉AI应该做哪些事,而不是不应该做哪些事:在提示词中告知不要AI输出某些内容,反而可能会提高这类输出的权重。这就如同告诉一个人“不要在脑中想象一头粉色的大象”

提示词使用第一人称:第三人称提示词下的AI是努力理解提示词,被动遵循用户指令的助手。而第一人称的提示词会让AI内化指令,以相对主动的方式来执行指令。(不能设置系统提示词也没有关系,可以用<system_prompt>标签来假装这是系统提示词)

实际即使在拉鲁斯自己的系统内,就我所见,官网、1995年法文版、双解版的音标有时也存在微妙的差异,这种神仙打架,一时难以裁定,为了省事,我个人通常会尊重底本,以双解版的原始图像为依据来处理,除非说它明确错了,才会予以修正更改。

我当下的目标定位是OCR、文本化《拉鲁斯法汉双解词典》。至于对词典本身全面编辑、校正,那学问可大了,自忖没这个能力也没这个时间,我曾经随机抽了一页词典文本让顶流 ai 挑刺查错,洋洋洒洒一大堆,说至少三五个“严重错误”,从古希腊语、原始日耳曼语讲到北非文化、普罗旺斯民俗,真真假假,煞有其事,要搞清楚明确得做大量的学术调查和研究。

Deepl

2025 年9 月 30 日 09:39

171

可能是我没表达清楚,我的意思是:通过对比ipa-dict的音标数据和《拉鲁斯》ocr文本的一致性,来检查《拉鲁斯》的音标文本是否存在ocr错误。两者毕竟都是用IPA对标准法语发音的纪录,排除对音位理解的不同后,差异应是极小的。但既然gemini输出的音标质量已经达到了你的要求,这就有点多此一举了

原书本身存在的问题根本不需要去管。我认为其实就连已发现的原书确实存在的错误也没有必要去修改,最多加一条校记即可。因为只是几处错误的修正在整部词典的体量面前实在是于事无补,而这却破坏了电子化文本与底本的一致性,给涉及词典版本的严谨研究造成不必要的麻烦。

给词典做修订不是电子词典制作者该做的工作。工作量太大,总会有失误的时候;而且没有同行评审,谁也不知道改的对不对。这种涉及到词典编纂和语言学的事情还是得交给专家来做。

现在的AI确实有能力辅助学者进行学术研究,但捏造事实的能力也是相当恐怖的,除非你是相关领域的专家,否则基本无法辨别内容的真实性。如果使用AI来做学术研究,使用者的学术水平至少得和AI同级,并且有方法能验证AI输出的内容。

2 个赞

现在音标对比有差异的地方也全校核过一遍了,功夫再深,可以一个个去对原书图像,这个工作我不打算做,就暂时到此为止。

如今剩下的主要问题是中法文的标点符号,以及空格使用的规范化。

a)中文文本相对比较少,也简短,标点错误很多是原作者、编辑的失误,比如何时该加句号(完整句子),何时删除(短语),出现的地方相对集中,我计划酌情编辑处理,尽量使其符合体例。

中文标点的另一个毛病是Gemini模型输出一般会统一使用半角的标点符号,像,;:?![]()等,其他则正常。我的看法是可改可不改,如果容易处理,不误伤法文标点,就统一改成全角符号,如果棘手,保持原样也没什么,还紧凑,节省文字空间。

b)法文的标点错误大致浏览了一下,不太多,经常是分号;看不清,误认为,,或者.给遗漏了,黑点句号遗漏还有两种情形,一种是ocr错误,一种是双解版本身给删了,或者弄丢了。这些问题具体如何处理,还需再议。

c)像 ❶❷❸◆◇→‖ 这些符号,前后有没有空格,目前很混乱,计划统一为前后各一个空格。v. i.,n. m.这些,按照双解版的情况,都留一个空格。法文和中文释义连接转换处,也均加一个空格。

1 个赞

做这个词典是以实用为目的的,又不是学术研究,我不可能改错还加个校记,即使加了,也没有合适的地方放置。真要有做词典版本学研究的,用这里OCR出来的电子版作为文本依据,那也是自己荒唐不学了。

至于改错,那也是以非常明显的为主,在github上所有的改动都有记录,有心稽核的人,不惮繁芜,可以去一一翻检查看 diff 数据。

1 个赞

我感觉空格问题不用处理,最后要结构化的话空格问题是直接忽略的。

Deepl

2025 年9 月 30 日 13:05

175

感谢你能为这部词典付出这么多精力和时间,我没想到这本书能有这么多低级错误。我没有要否定你的劳动价值的意思。

我谈论和建议加校记的是释义、音标、义项之类的主体内容,我希望无论如何也要保留这些内容的原貌。《汉语大词典》光盘版的前车之鉴大家都很清楚吧?光盘制作者和后续修改者随意窜改内容还不加校记的做法实在让人头疼。至于写错标点、写错字和格式不一这种低级错误当然没有保留原貌和加校记的必要。这是词典编辑的错误而不是学术性错误。文本格式上的问题只关乎文本的使用体验,作为电子词典的制作者当然是能改就改。

你说的原文标点失误,体例不一的问题确实很棘手,但MDX是基于HTML的文件,这种问题只取决于你想要用怎样的方法解决。

使用电子化文本进行学术研究的问题,我相信只要有内容基本准确的电子版可用,没有学者想要在纸本上进行所有研究工作。高效的做法是用电子版查询一些一旦出错可以一眼看出的内容,只在有必要确认内容准确性的时候再动手翻检纸本。但LLM OCR相比传统方法多了一层AI幻觉的可能,你说的对,学术研究确实不应该使用AI输出的文本。

hua

2025 年10 月 1 日 10:00

176

26 个帖子被拆分为一个新话题:《汉语大词典》相关讨论

Deepl:

释义、音标、义项之类的主体内容

它们基本没动过,改的是错别字和明显荒唐的音标,比如有一处音标是:

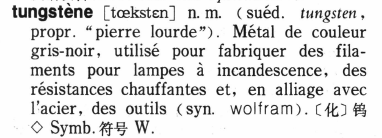

tungsten是不大可能开始发 tœ 这个音的,去查了下法文版,注音为 [tœ̃kstɛn],那只能改了。又去复查了一下,不知道为什么我还给改错了,成了 [tœ̃̃kstɛn],可能上面的小蚯蚓在编辑器里捣鬼,待下次再修正。

晚近有网友慷慨赠送了一份清晰版的《拉鲁斯法汉双解词典》PDF,真令人悲喜交感。喜的是屡年寻找,踏破铁鞋无觅处,如今则得来全不费工夫,悲的是,我以它为底本让合合、Gemini 2.5 Pro重新实验性扫描识别,其结果也颇有讹误,相对目前文本校改的程度而言,已经没有太多对照纠谬的价值。

不过总体而言这是一个佳音,表明拉鲁斯双解的文本处理质量还是不错,没有漏洞百出,以致遗讥腾笑世间。

我把以清晰版为底本OCR识别的结果(前25页)贴在这里,供感兴趣的人参考。

25 - TextIn.txt (145.8 KB)25 - Gemini.txt (141.9 KB)

另附:

目前法文文本的分号;问题大部分已经处理纠正,但西文句点.毛病稍微有点复杂,大致来看存在四种情形:1)法文本误,双解版沿袭同误;2)法文本不误,双解版编校失误,增删而误;3)双解版更改体例标准故意删除;4)OCR错误而增删句点。仔细考究比较麻烦,我打算先依照双解版图像粗改一通再说。

1 个赞

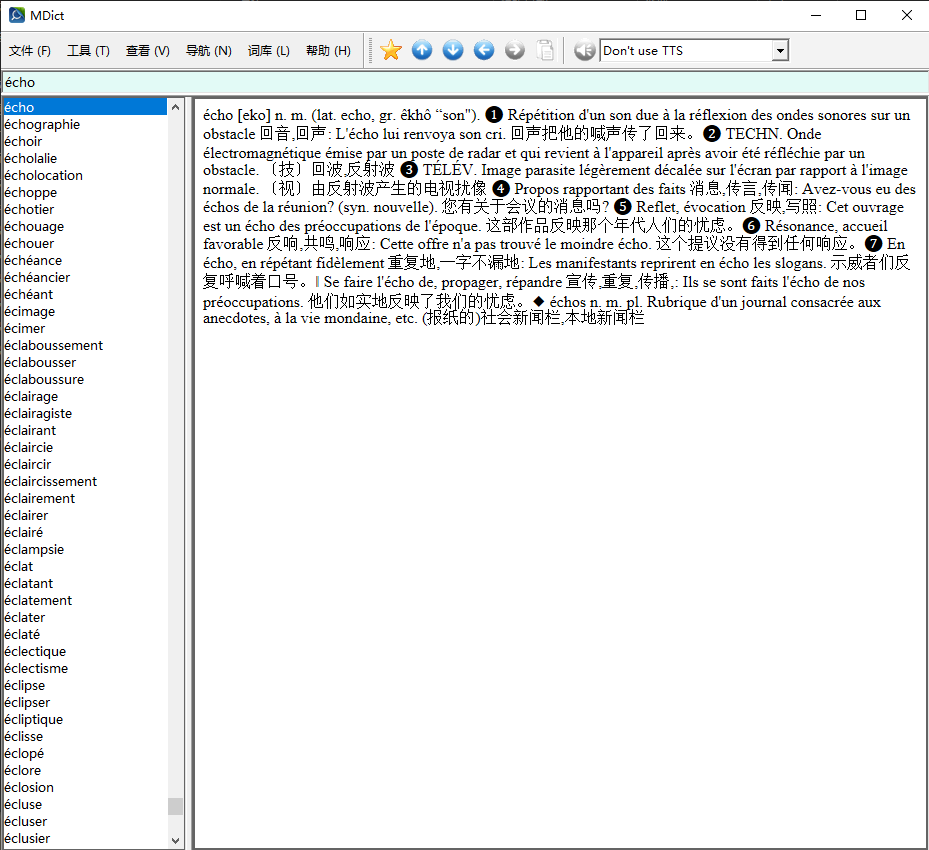

用 github 上的json文件生成了一个没有任何格式的mdx词典,它当然不美观,很简陋,但主要目的是预览查错用的,更完善的形式以后再说。

拉鲁斯法汉双解词典.mdx (5.5 MB)

从 json 生成 mdx 源文件的的简单脚本也贴在这里,可以随时自己根据最新版的json制作预览版mdx。

import json

def create_mdx_source(input_json_path, output_txt_path):

"""

将JSON文件转换为用于制作MDX词典的源文本文件。

输出格式为:

headword

text

</>

参数:

input_json_path (str): 输入的JSON文件路径。

output_txt_path (str): 输出的MDX源文本文件路径。

"""

try:

with open(input_json_path, 'r', encoding='utf-8') as f:

data = json.load(f)

except FileNotFoundError:

print(f"错误:找不到文件 '{input_json_path}'")

return

except json.JSONDecodeError:

print(f"错误:文件 '{input_json_path}' 不是有效的JSON格式。")

return

# 打开输出文件准备写入

with open(output_txt_path, 'w', encoding='utf-8') as f_out:

# 遍历JSON数据中的每一个词条

for entry in data:

# 检查词条中是否包含'headword'和'text'键

if 'headword' in entry and 'text' in entry:

headword = entry['headword']

text = entry['text']

# 按照指定格式写入文件

f_out.write(headword + '\n')

f_out.write(text + '\n')

f_out.write('</>\n')

else:

# 如果某个条目缺少关键信息,可以打印一个警告

print(f"警告:跳过一个不完整的条目: {entry}")

print(f"处理完成!MDX源文件已成功生成并保存到 '{output_txt_path}'。")

# --- 程序执行 ---

if __name__ == "__main__":

# 设置输入和输出文件名

input_file = '拉鲁斯法汉双解词典.json' # 你的JSON文件名

output_file = 'mdx_source.txt' # 你希望生成的MDX源文件名

create_mdx_source(input_file, output_file)

3 个赞

haoshu

2025 年10 月 4 日 06:39

181

有无可能搞个文字+切图对照版mdx?这就方便使用的过程中校对了。

1 个赞

技术上没有问题,比较简单,图已经切了,索引也有,但我个人觉得没这个必要。因为双解版原书错讹颇多,在文本化的过程有所校改,图文一对照,细微处二者不符,令人反生疑窦。

本词典的编校相对粗疏,无论中法版皆如此,不是那种千锤百炼的出版经典,没有太高的权威版本价值。

另一方面,由于学法语的人不多,法汉词典比起英汉词典,甚至日汉词典来说,精耕细作的程度那是差太远了。《拉鲁斯法汉双解词典》跟《牛津高阶英汉双解词典》这些就不是一个类别和档次,只能算是矮子里的将军,贵在保留了法文释义,中文含糊处可供稽考,更上一层楼,或许只能用Petit Larousse等纯法文工具书。

xliley

2025 年10 月 6 日 00:48

184

非常感谢,也觉得图文对照版也有些用,如果不是很麻烦,恳请也做一个出来。

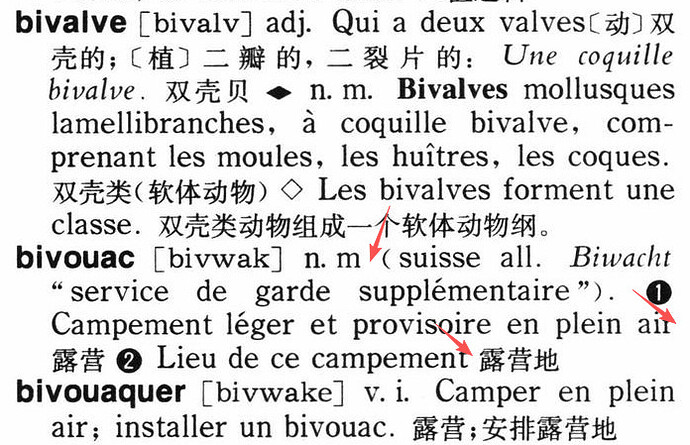

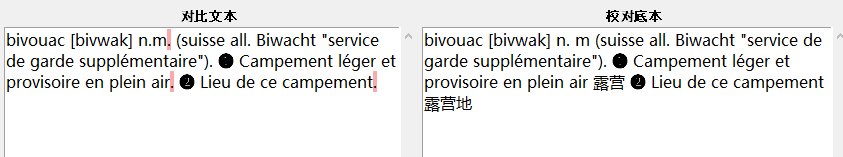

看一处典型的《拉鲁斯法汉双解词典》编校失误,一个单词里面错了三个标点。截图给出了更多内容,通过上下文可以了解词典本身的体例。

bivouac [bivwak] n.m. (suisse all. Biwacht “service de garde supplémentaire”). ❶ Campement léger et provisoire en plein air. ❷ Lieu de ce campement.

bivouac [bivwak] n. m (suisse all. Biwacht “service de garde supplémentaire”). ❶ Campement léger et provisoire en plein air 露营 ❷ Lieu de ce campement 露营地

图文对照版做出来难度不大,但体积狼犺,下载、存储不便,多少人真用得上我比较怀疑。不过对此我持开放态度。

jdiary

2025 年10 月 8 日 11:59

187

也给图文对照版投一票。把全部图片打包到一个mdd里面,应该也还算是方便的。另外,你上面的文本对比,我觉得原始图片里面是正确的啊,也就是校对底本是正确的。m后面不需要点是因为表示阳性名词吧。两项释义法文没有点更为常见,因为并不是完整句子。当然,这里也取决于词典整体风格。不影响理解最为重要啦。保留原始图片总是多一种检验。能帮助确切理解法语。

增上慢

2025 年10 月 8 日 12:07

188

mixivivo:

图文对照版做出来难度不大,但体积狼犺

不想要图的可以直接删掉mdd(体积不算什么问题),但对于要使用对照版的人来说,有利于勘误。